17:17 PM, MST, George Bush International Airport, Houston, Texas, Estados Unidos.

Intro

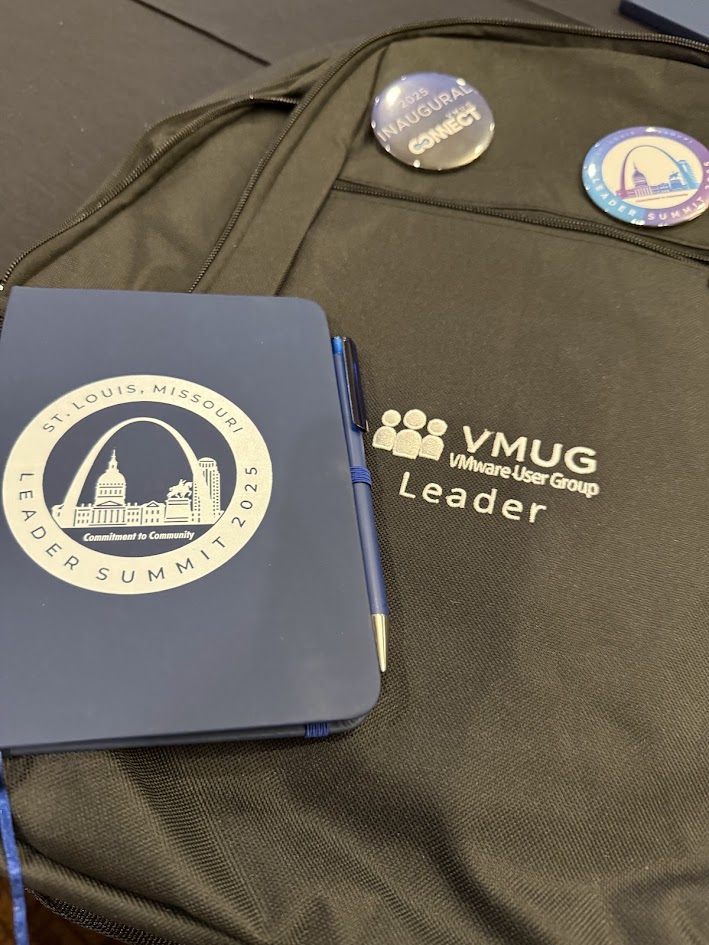

Después de dos horas de vuelo y otras dos horas de demora (¡qué vergüenza, United!) tengo un rato antes de mi próximo vuelo para sentarme a reflexionar y escribir en mi cuadernito (sí, ahora escribo en papel) lo que pasó en estos días.

Volvamos a 2024 por un par de líneas:

Aproximadamente en noviembre de 2024 desde VMUG HQ nos avisaron que iban a hacer un VMUG Connect en St. Louis, Missouri. Un evento de 3 días lleno de charlas técnicas, oportunidades de desarrollo profesional y charlas con gente muy picante en VMware by Broadcom. También se iba a dar el primer Leader Summit desde 2022.

Todos los líderes estaban invitados pero había que registrarse y la invitación se iba a sortear. Lamentablemente no gané el sorteo para ir.

El 17 de marzo de 2025 estaba en un vuelo hacia Japón cuando, por algún motivo, decidí mirar los mails y vi que había quedado seleccionado. Golazo de media cancha. Confirmé en la oficina (gracias Matt), sacamos los pasajes y quedó todo confirmado.

Leader Summit

El martes 22 a las 15:30 hs hice el check-in para el VMUG Leader Summit 2025. La verdad que no sabía demasiado qué esperar, nunca había interactuado mucho con otros líderes de VMUG más allá de los de mi comunidad.

Mientras hacíamos el check-in, nos presentamos, charlando de nimiedades (¿De dónde sos? ¿Qué hacés? ¿A qué te dedicás? etc.).

Ahora, ¿qué es el Leader Summit? Es una reunión global donde participan los líderes de VMUG de todas las regiones.

Definitivamente fue una gran experiencia para saber qué está pasando en la comunidad de usuarios a nivel global, explorar nuevas ideas para los eventos de VMUG Buenos Aires y escuchar a Broadcom en relación a los eventos de los últimos años.

No fue un evento precisamente técnico, fue más bien administrativo y de networking.

Esa noche tuvimos el inicio del evento en el estadio de los Cardenales de St. Louis, donde pudimos ver un poquito del mundo del béisbol, al cual, como argentino, soy completamente ajeno.

Al día siguiente siguieron las distintas charlas relacionadas al Leader Summit y le dimos inicio al VMUG Connect en la cervecería Anheuser-Busch, donde se creó la cerveza Budweiser.

VMUG Connect – El evento

Antes de que me pregunten, ¿qué es VMUG Connect?

Le pregunté a ChatGPT y esta es la definición:

VMUG Connect es un evento de pago de VMUG, la organización independiente de usuarios de VMware, que ofrece contenido de alto nivel para sus miembros. Permite a los asistentes construir una agenda personalizada, con acceso a sesiones, paneles, oportunidades de networking y más, enfocados en sus intereses y objetivos de desarrollo profesional. Es una adición reciente a la experiencia de VMUG, ofreciendo conocimientos de la industria, encuentros exclusivos, demos de productos y otros recursos.

Durante el evento hubo más de 40 sesiones dentro de 4 caminos: VCF, Hands on Labs, Thriving in Tech y Tech Use Cases.

La apertura del evento fue una charla compartida entre Pablos Holman, el reconocido inventor y hacker, y Frank Denneman, que nos explicó cómo funciona VMware Private AI y nos dio varios casos de uso.

Algunas de mis charlas favoritas del evento fueron:

- You are not ready: Stories from a Cyber Incident Survivor – Steve Athanas.

¿De qué se trata? Steve nos contó su experiencia en un ciberataque bastante grande.

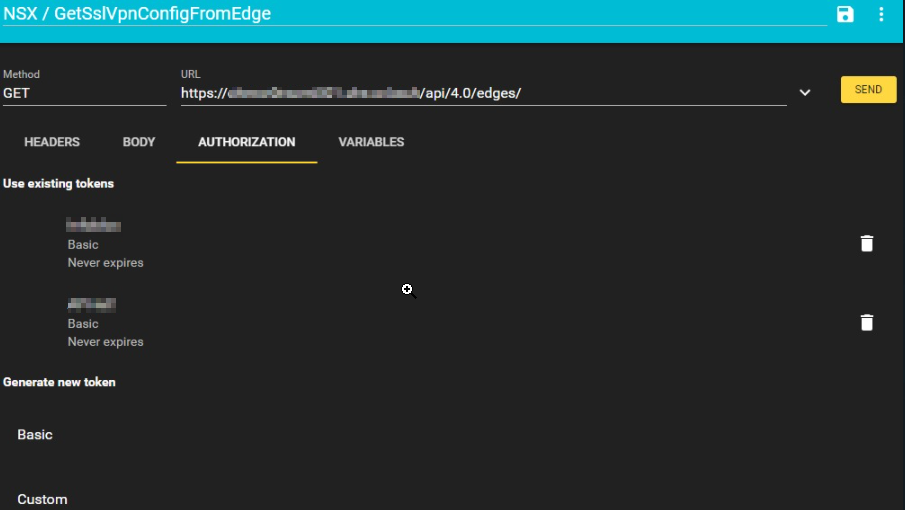

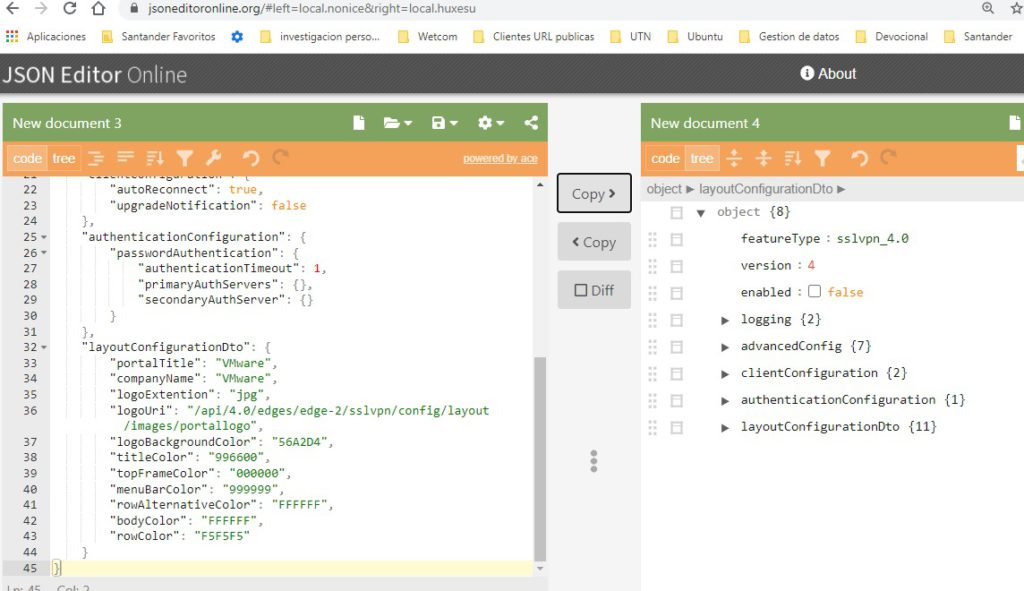

¿Por qué me gustó? Steve es un orador excelente, tiene un manejo de los tiempos en el escenario y una claridad para hablar que son envidiables. - Automating NSX with Terraform – Maarten Van Driessen

¿De qué se trata? Es una sesión de 45 minutos sobre cómo automatizar NSX con Terraform, bien para principiantes. Arranca dando un caso de uso básico (crear un segmento) y pasa a algo más avanzado (automatizar las reglas del DFW).

¿Por qué me gustó? Todo el mundo entiende el concepto de SDN (Software Defined Networking), sin embargo, al no aprovechar las capacidades del SDN de hacer infraestructura como código (IaC), estamos desaprovechando sus capacidades. - A Look Inside the Future of VMware Cloud Foundation – Weiguo He

¿De qué se trata? Fue una demostración de lo que se viene con VCF 9 y la estrategia de Broadcom a futuro.

¿Por qué me gustó? Fue un primer vistazo general a VCF 9, nos pidieron que no saquemos fotos ni publiquemos nada, pero siento que después de varias iteraciones del producto lograron integrar todos los componentes, y no pegarlos con chicle como pasaba en versiones anteriores, para dar una competencia más que digna a un hyperscaler. - AMA con William Lam

¿De qué se trata? Ask Me Anything (Preguntame cualquier cosa) es una charla más bien informal con alguien relevante en la industria. Le pudimos preguntar cualquier cosa a William Lam: desde cómo maneja sus tiempos para escribir, si compra o no su propio hardware, qué podcasts le gustan, etc.

¿Por que me gustó?

Una imagen dice mas que mil palabras.

- Sesión General:

Básicamente, en esta sesión general hubo 2 charlas.

En la primera, Hock Tan y Chris McCain (CEO de Broadcom) nos contaron la estrategia de Broadcom a futuro.

Hock dejó muy en claro que VCF es el camino para todos los clientes y dijo algo que me pareció muy cierto: “Pagué 69 billones de dólares por esta empresa, quiero hacer crecer ese dinero”.

Algo que me gustó mucho fue que en el evento había un centro de exámenes Pearson VUE y que los miembros de VMUG Advantage (es decir, los VMUG Leads) podían certificarse gratis.

Pude rendir el examen VCP-VCF completamente gratis.

Por otro lado, algunos clientes de VMware que renovaron sus licencias o adquirieron VCF nos contaron sus experiencias en ese proceso. Esta charla fue moderada por Matt Heldstab y participaron Eric Kubla, Wil Gonzalez, Justin Sider y Marc Crawford.

Por último, esa noche fuimos a ver el partido de los Cardinals.

Fue una súper grata experiencia poder compartir esto con otros miembros de la comunidad (por cierto, gracias Matt por explicarme cómo funciona el deporte más complicado del mundo).

Nos vemos la próxima.

Nacho.